ARアドカレ 9日目の代理投稿です。AR歴5年目のあっしゅ (@ashyanagisawa) がお送りします。

■ はじめに

台湾・韓国・日本の3カ国で同時オンライン中継で開催されたAsia Open Data Hackathon 2018。私が所属したチーム「STANDY」は最優秀賞「Invincible Hackers」とスポンサー賞「HERE International Award」を獲得し、韓国での授賞式に参加しました。

今回、Semantic Segmentationを活用した受賞作品「Sentiments in AR」についてご紹介します。

■ ツイートから感情を分析

同国際ハッカソンの今年のテーマは「観光」と「市民安全(防災)」。

観光で見知らぬ土地に赴いたときや災害にあったとき、一般的なWebページで得られる情報だけでは不十分な場合があります。「Sentiments in AR」は、誰かがツイートした内容からその感情を分析し、空に可視化する表現方法です。複数の感情から災害を検知し、最寄りの避難所を示します。避難所から発生する音は空間音響 (Spatial Sound)に対応しているので、耳で瞬時に方向の把握が可能です。

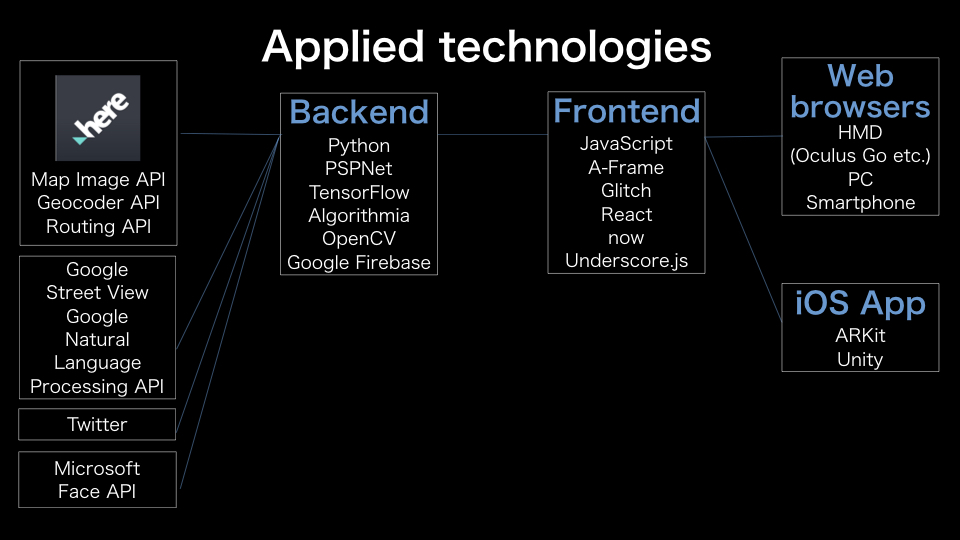

フロントエンドの実装はWebVRフレームワークのA-Frameです。以下のデモは、スマホだけでなく、Oculus GoのWebブラウザ上でも動作します。

■ 顔の表情から感情を分析

別のアプローチとして、スマホやウェアラブル端末のカメラから得たデータに含まれる人の顔をリアルタイムで感情分析するデモも作成しました。以下のVimeo動画は、キャプションで同内容を説明していますので、CCをオンにして再生することを推奨します。

■ Sentiments in ARの仕組み

■ Asia Open Data Hackathon 2018の感想

グローバルメンバーと英語でコミュニケーションし、同国際ハッカソンをやり終えたことは、私にとって貴重な経験になりました。来年の表彰式は東京です。もし興味がある方は是非参加してみてください!